In questo articolo, “Container, microservizi e orchestratori”, impariamo a conoscere cosa sono i Container, perchè sono nati e quali vantaggi offrono. Esploreremo i concetti fondamentali delle applicazioni multilayer, dei moduli che costituiscono l’applicazione stessa fino ad arrivare al concetto di microservizi. Introdurremo Dockers e Kubernetes e, dopo aver imparato i concetti fondamentali possiamo fare riferimento alla guida Dockers all’interno della quale troviamo una sezione per implementare un docker container, realizzare un’applicazione e testarne il funzionamento.

Indice dei contenuti

Introduzione

Nel 2013 alcuni tecnici di Google si posero una domanda fondamentale che avrebbe influenzato profondamente il modo di sviluppare e distribuire applicazioni software:

Perché virtualizzare un’intera macchina quando sarebbe possibile virtualizzare solo ciò che serve realmente all’applicazione?

Per comprendere l’origine di questa riflessione è necessario fare riferimento alle tecnologie precedenti e alle difficoltà operative che gli sviluppatori affrontavano.

In passato, uno sviluppatore che desiderava testare la propria applicazione su sistemi operativi differenti doveva necessariamente disporre di più macchine fisiche, ciascuna con un sistema operativo diverso, oppure utilizzare hard disk separati da installare e configurare di volta in volta sulla stessa macchina. Questo approccio risultava costoso, complesso da gestire e poco flessibile, soprattutto in contesti di sviluppo e test frequenti.

Per superare tali limitazioni, si è diffusa una prima importante rivoluzione tecnologica: la virtualizzazione.

La virtualizzazione consente di eseguire più sistemi operativi sulla stessa macchina fisica, sfruttando un livello software intermedio (hypervisor) che astrae l’hardware sottostante. In questo modo è possibile creare più macchine virtuali (VM), ciascuna con il proprio sistema operativo, isolata dalle altre.

Questa soluzione ha permesso di migliorare la portabilità delle applicazioni e l’isolamento degli ambienti, ma presenta anche limiti significativi. Le macchine virtuali, infatti, devono includere un sistema operativo completo, con tutti i servizi annessi, anche quando non strettamente necessari all’esecuzione dell’applicazione. Di conseguenza, la virtualizzazione richiede hardware molto performante e comporta un consumo elevato di risorse. In alcuni casi, le prestazioni risultano inferiori alle aspettative, specialmente quando più macchine virtuali condividono lo stesso host.

È proprio da questa constatazione che nasce l’idea dei tecnici di Google: per testare o distribuire un’applicazione non è necessario virtualizzare un intero sistema operativo, ma solo l’ambiente minimo indispensabile per farla funzionare.

I container

I container rappresentano un’alternativa più leggera ed efficiente rispetto alle macchine virtuali per fornire ambienti di esecuzione isolati. A differenza della virtualizzazione tradizionale, i container non utilizzano un hypervisor e non includono un sistema operativo completo, ma condividono il kernel del sistema operativo host.

Ogni container contiene esclusivamente l’applicazione e tutte le sue dipendenze: librerie, file di configurazione, variabili d’ambiente e runtime necessari. Questo approccio consente di eliminare l’overhead tipico delle macchine virtuali e di ottenere ambienti più compatti, veloci ed efficienti.

Grazie a questa struttura, i container possono essere avviati e arrestati in tempi estremamente ridotti, rispondendo rapidamente alle esigenze di scalabilità. Inoltre, le prestazioni risultano generalmente superiori rispetto alle VM, poiché l’applicazione viene eseguita più vicino all’hardware reale.

Un ulteriore vantaggio fondamentale è la portabilità: un container può essere eseguito senza modifiche su ambienti diversi, come il computer dello sviluppatore, un server di test o un’infrastruttura cloud di produzione, evitando i classici problemi di incompatibilità tra ambienti.

Vantaggi dei container

L’utilizzo dei container introduce numerosi benefici nello sviluppo e nella distribuzione del software.

Innanzitutto, i container sono indipendenti e autosufficienti: ogni container è un pacchetto software completo che include tutto ciò che serve per l’esecuzione dell’applicazione, senza dipendere dalla configurazione del sistema ospitante.

Dal punto di vista delle risorse, i container sono leggeri, poiché non virtualizzano l’intero sistema operativo. Questo consente un uso più efficiente dell’hardware e una gestione ottimizzata delle prestazioni, soprattutto in ambienti con molte applicazioni in esecuzione.

La portabilità rappresenta un ulteriore punto di forza: un container può essere facilmente trasferito ed eseguito su un’altra macchina senza la necessità di configurazioni aggiuntive o di hardware dedicato.

I container garantiscono inoltre isolamento e sicurezza. Ogni container opera come un’unità software autonoma, separata dalle altre, riducendo il rischio di interferenze tra applicazioni e aumentando l’affidabilità complessiva del sistema.

Infine, la facilità di distribuzione è un aspetto chiave: i container possono essere archiviati e scaricati da repository centralizzati, assicurando che l’ambiente di esecuzione sia identico indipendentemente dal dispositivo o dall’infrastruttura utilizzata.

Una nuova rivoluzione nello sviluppo software

La disponibilità dei container ha cambiato radicalmente il modo di progettare le applicazioni.

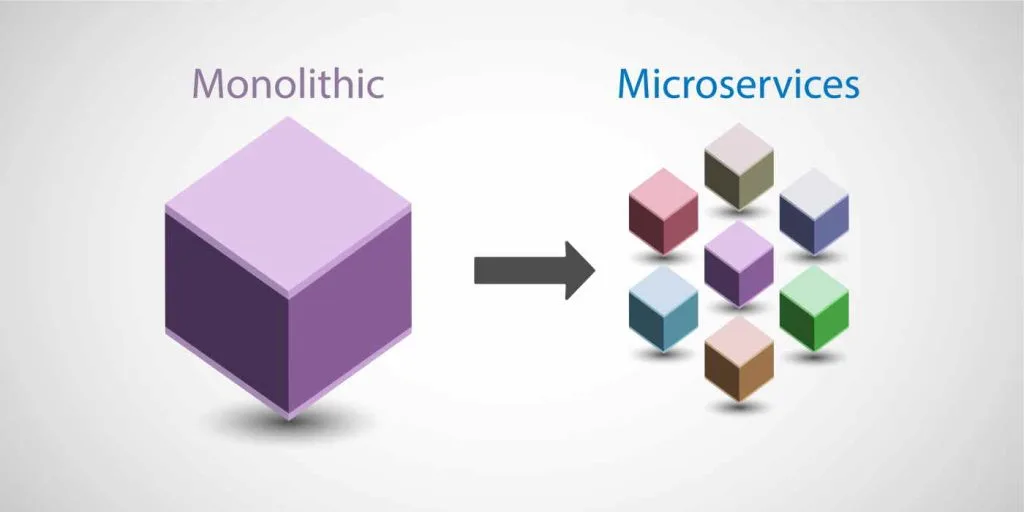

Se in passato lo sviluppo era prevalentemente di tipo monolitico, oggi è possibile adottare un approccio modulare, suddividendo un’applicazione complessa in componenti più piccoli e indipendenti.

Ogni modulo deve essere autosufficiente e in grado di comunicare con gli altri attraverso interfacce ben definite. In questo contesto nasce il concetto di microservizi: un’architettura in cui un’applicazione è composta da una serie di servizi autonomi, ciascuno responsabile di una specifica funzionalità.

Spingendo ulteriormente questo modello, è possibile progettare ogni microservizio come un container, ottenendo un’architettura a microservizi containerizzati, altamente flessibile e scalabile.

Esempio: applicazione E-commerce

Consideriamo un sito di E-commerce.

In un approccio monolitico tradizionale, tutte le funzionalità — gestione utenti, catalogo prodotti, carrello, ordini e pagamenti — sono incluse in un’unica applicazione.

Con un’architettura a microservizi, invece, l’applicazione viene suddivisa in servizi indipendenti, ciascuno dedicato a una funzione specifica. Ogni servizio può essere sviluppato, aggiornato e scalato in modo autonomo.

In un sistema E-commerce tipico possiamo individuare microservizi come:

- gestione degli utenti e dell’autenticazione;

- gestione del catalogo prodotti;

- gestione del carrello;

- gestione degli ordini;

- gestione dei pagamenti;

- invio di notifiche;

- interfaccia frontend;

- API Gateway come punto di accesso unificato.

Questa suddivisione consente l’uso di tecnologie diverse per ciascun servizio e rende l’intero sistema più flessibile e manutenibile.

Architettura a microservizi

L’architettura a microservizi è un paradigma di progettazione secondo cui un’applicazione è composta da una collezione di servizi indipendenti e distribuiti, ciascuno responsabile di una funzione specifica.

Questa struttura si integra perfettamente con i container, che permettono di isolare ogni microservizio e di controllarne in modo preciso l’utilizzo delle risorse.

Secondo diverse analisi di settore, tra cui quelle di Gartner, il modello a microservizi si basa su componenti debolmente accoppiati e scalabili in modo indipendente.

L’indipendenza rappresenta l’elemento chiave di questo modello.

A differenza delle applicazioni monolitiche, in cui una modifica richiede spesso la ricompilazione e la ridistribuzione dell’intero sistema, i microservizi consentono aggiornamenti mirati e scalabilità selettiva. Questo approccio è particolarmente adatto agli ambienti cloud moderni, dove flessibilità e rapidità di distribuzione sono essenziali.

La comunicazione tra microservizi avviene tramite API, generalmente basate su protocolli standard come HTTP/REST, gRPC o sistemi di messaggistica asincrona. Ciò consente l’interoperabilità tra servizi sviluppati con linguaggi diversi e distribuiti su nodi differenti della rete.

Gli Orchestratori

All’aumentare del numero di microservizi, cresce anche la complessità della loro gestione.

È qui che entrano in gioco gli orchestratori, piattaforme software che automatizzano il ciclo di vita dei container.

Un orchestratore si occupa del deployment, della scalabilità automatica, del monitoraggio dello stato dei servizi e del ripristino automatico in caso di errore. Gestisce inoltre il bilanciamento del carico, la comunicazione tra i servizi, le reti virtuali e i volumi di storage persistente.

Il più diffuso orchestratore è Kubernetes, originariamente sviluppato da Google e oggi mantenuto dalla Cloud Native Computing Foundation. Kubernetes consente di descrivere l’intera architettura dell’applicazione tramite file di configurazione, definendo servizi, repliche, risorse e modalità di esposizione verso l’esterno.

In conclusione, l’orchestratore rappresenta il livello di controllo intelligente che rende possibile la gestione efficiente di sistemi complessi basati su microservizi containerizzati, garantendo affidabilità, scalabilità e continuità operativa negli ambienti cloud-native.

Conclusioni

L’evoluzione dalle macchine fisiche alla virtualizzazione e, successivamente, ai container rappresenta una delle trasformazioni più significative nello sviluppo e nella distribuzione delle applicazioni moderne. Se la virtualizzazione ha costituito un primo passo fondamentale per migliorare la portabilità e l’isolamento degli ambienti di lavoro, i container hanno introdotto un approccio più efficiente, leggero e flessibile, rispondendo in modo più efficace alle esigenze dei sistemi software contemporanei.

Grazie alla condivisione del kernel del sistema operativo e all’eliminazione dell’overhead legato a sistemi operativi completi, i container consentono di eseguire applicazioni in modo rapido, scalabile e altamente portabile. Questo modello si integra perfettamente con l’architettura a microservizi, che permette di progettare applicazioni complesse come insiemi di servizi autonomi, indipendenti e facilmente manutenibili.

L’adozione dei microservizi containerizzati favorisce una maggiore modularità del software, semplifica gli aggiornamenti, migliora la resilienza del sistema e consente una scalabilità selettiva delle singole funzionalità. Tuttavia, tale approccio introduce anche una maggiore complessità gestionale, che rende indispensabile l’utilizzo di strumenti di orchestrazione come Kubernetes.

In conclusione, container, microservizi e orchestratori costituiscono oggi i pilastri delle architetture cloud-native. Comprendere questi concetti è fondamentale per interpretare correttamente le tecnologie attualmente utilizzate nel mondo professionale e per affrontare con consapevolezza le sfide dello sviluppo software moderno, sempre più orientato a flessibilità, automazione e scalabilità.

Lascia un commento